Синтетические данные: новый подход к обучению искусственного интеллекта

Синтетические данные становятся важным инструментом в обучении ИИ. Стартапы обучают свои модели с помощью таких данных, чтобы преодолеть ограничения реальных данных.

Искусственный интеллект столкнулся с ограничением: объем данных для обучения исчерпывается. В этой ситуации стартапы находят выход в синтетических данных — информации, созданной другими нейросетями.

Такие компании, как Anthropic, применяют синтетические данные для обучения своих моделей, например, Claude 3.5 Sonnet. Meta адаптировала свои нейросети Llama 3.1 с использованием таких данных, а OpenAI также использует синтетическую информацию для обучения своей модели o1 — «рассуждающего» искусственного интеллекта.

Издание TechCrunch выделяет плюсы и минусы данного подхода.

Краткий обзор

Системы ИИ представляют собой статистические машины, которые обучаются на большом количестве примеров и выявляют закономерности для дальнейшего прогнозирования.

Ключевым элементом в этих примерах являются аннотации — метки, которые определяют смысл или составляющие данных. Они помогают модели различать объекты, места и идеи.

Например, если нейросети предоставить множество фотографий кухни с нашим меткой «кухня», она начнет ассоциировать общие характеристики, такие как холодильник или столешница. После обучения модель сможет распознавать новые изображения кухни.

Важно правильно классифицировать аннотации: если изображения кухонь пометить словом «корова», ИИ начнет связывать холодильник с животным.

Этот спрос на аннотации данных создал целый рынок, стоимость которого оценивается в 838,2 миллиона долларов и ожидается, что к 2032 году он достигнет 10,34 миллиарда долларов.

Некоторые виды аннотации требуют специализированных знаний. Существуют компании, занимающиеся аннотацией данных, где работа может быть как высокооплачиваемой, так и низкооплачиваемой — в развивающихся странах аннотаторы зарабатывают менее 2 долларов в час по данным исследований.

Необходимость автоматизации

Оплата труда аннотаторов может быть высокой, а также они могут допускать ошибки. Кроме того, получение данных становится все более затратным: Shutterstock требует десятки миллионов долларов от поставщиков ИИ за доступ к своим архивам, а Reddit заработал сотни миллионов на лицензировании информации для Google, OpenAI и других.

К тому же с каждым годом доступ к данным осложняется: более 35% из 1000 лучших веб-сайтов блокируют доступ для OpenAI. Продолжение этой тенденции может привести к тому, что к 2026–2032 годам ИИ обезопасит все общедоступные данные.

Эти трудности, а также риски судебных и исков за использование лицензированной информации, подчеркивают необходимость создания синтетических данных.

Синтетические решения

Если данные обозначаются как «нефть», синтетическая информация может быть сравнима с «биотопливом», создаваемым без вреда для окружающей среды, отмечает кандидат наук из Вашингтонского университета Ос Киз.

«Вы можете начать с небольшого набора данных и моделировать, экстраполируя новую информацию», — утверждает он.

Индустрия ИИ быстро принимает эту технологию. В декабре компания Writer представила модель Palmyra X 004, которая была почти полностью обучена на синтетических данных, что обошлось всего в 700 000 долларов, по сравнению с 4,6 миллиона долларов, потраченных OpenAI на создание аналогичной модели.

Открытые модели Phi от Microsoft также были частично обучены на синтетических данных, как и Gemma от Google. Летом Nvidia представила новое семейство моделей, призванных создавать синтетическую обучающую информацию, а стартап Hugging Face предложил «самый большой» набор для настройки ИИ из искусственного текста.

Рынок генерации синтетических данных способен достичь 2,34 миллиарда долларов к 2030 году.

Риски синтетических данных

Однако использование синтетических данных несет определенные риски. Если исходные данные, используемые для генерации искусственной информации, имеют предвзятость или ограничения, результат будет негативно приспособлен.

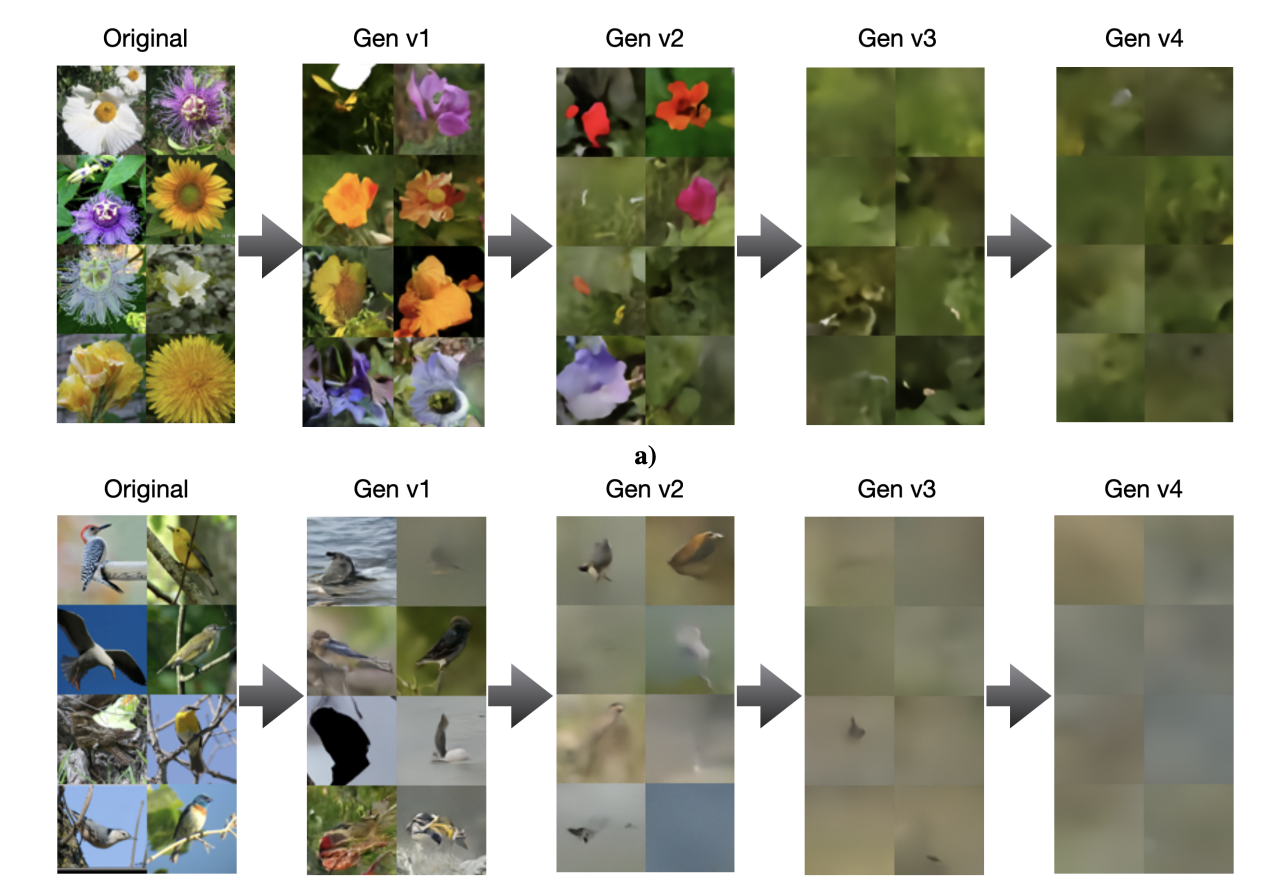

Чрезмерное использование синтетических данных может привести к снижению качества и разнообразия моделей. По исследованию Университетов Райса и Стэнфорда, крупные нейросети, такие как o1, создают сложные для обнаружения «галлюцинации», что снижает точность ИИ, обученного на таких данных.

Исследование показало, что модели, обученные на ошибочных данных, генерируют еще более ненадежные результаты, что создает порочный круг, усиливающий проблему. ИИ может начать выдавать ответы, не имеющие никакой связи с вопросом.

Другое исследование доказывает снижение качества работы модели на примере изображений.

Лука Солдайни, старший научный сотрудник Института искусственного интеллекта Аллена, считает, что использование синтетических данных оправдано при условии их тщательной проверки и сопоставления с реальной информацией.

Интересно, что пренебрежение этими условиями может привести к краху модели, уменьшению ее «творческого» потенциала и серьезному снижению функциональности.

«Конвейеры синтетических данных не являются самосовершенствующимися машинами. Их результаты должны быть тщательно проверены и улучшены перед использованием для обучения»,

CEO OpenAI, Сэм Альтман, предполагает, что в будущем ИИ сможет создавать достаточно качественные синтетические данные для эффективного самообучения.

Отметим, что в декабре Илья Суцкевер, соучредитель OpenAI, предсказал конец эпохи предварительного обучения ИИ и появление суперинтеллекта.